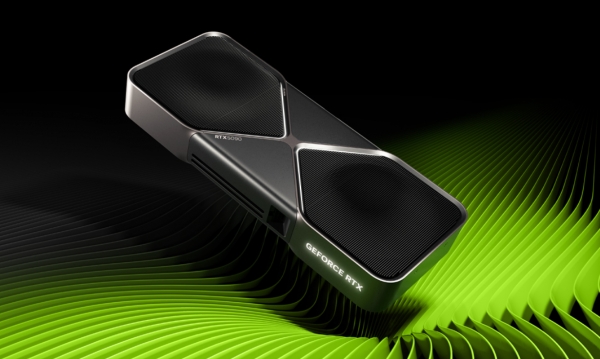

CES 2025에서 엔비디아의 CEO 젠슨 황은 물리적 AI 개발 플랫폼인 ‘NVIDIA Cosmos’와 개인용 AI 슈퍼컴퓨터 ‘Project DIGITS’를 발표하며 글로벌 기술업계의 이목을 집중시켰다. 특히 엔비디아의 신제품 GPU ‘GeForce RTX 50’ 시리즈는 전 세계적으로 높은 관심을 받았다. 이는 GPU 기술이 단순한 그래픽 처리를 넘어 다양한 산업과 연구 분야에서 핵심적인 임무를 수행하고 있음을 여실히 보여준다.

GPU는 Graphic Processing Unit의 약자로, 그래픽 처리와 기계학습의 행렬 연산 등을 가속하는 컴퓨터 하드웨어 장치다. GPU는 모든 처리 장치가 한 프로그램상의 서로 다른 작업을 동시에 처리함으로써 처리 과정의 부하를 분담해 속도를 향상하는 병렬 처리 능력을 갖추고 있다. 특히 GPU의 뛰어난 연산속도는 딥러닝 기술의 탄생에 크게 이바지했다. 현재 AI 학습과 추론에 필요한 대부분의 연산은 전통적인 CPU(Central Processing Unit) 대신 GPU 또는 AI 가속기에서 처리된다. GPU의 지속적인 발전이 거대 AI 모델 개발과 성능 향상의 토대가 된 것이다. 만약 GPU가 없었다면 ChatGPT와 같은 기술은 여전히 상상 속에 머물러 있었을 것이다. 또한 고성능 컴퓨팅 분야에서도 상위권의 슈퍼컴퓨터는 GPU에서 대부분의 성능이 나온다.

GPU의 역할은 점차 확대되면서 △머신러닝 △AI △블록체인 등 미래 기술의 핵심 요소로 자리매김했다. 또한 △대규모 금융 △국방 애플리케이션 △과학 시뮬레이션 등 고성능 컴퓨팅이 요구되는 분야에서도 광범위하게 활용되고 있다.

그러나 GPU 기술의 지속적인 발전 속에서도 해결해야 할 기술적 과제와 새로운 도전 과제는 여전히 존재한다. 우리대학 김광선(컴공) 교수는 “GPU의 연산기와 메모리 성능을 계속 높이는 작업은 끝이 없을 것이다. 하지만 연산 성능보다 메모리의 발전 속도가 훨씬 느리므로 메모리 병목이 점점 더 큰 문제가 될 것이다. 최근 AI는 더욱 큰 사용자 요청과 데이터를 한 번에 처리하고 생각사슬(Chain-of-Thought) 방식을 많이 활용하며 외부 데이터베이스를 이용하는 방향으로 발전하고 있다. 이는 모두 메모리 병목을 더욱 악화시키는 문제가 있다”라며 “연산 측면에서도 단순히 최대 성능만 높일 것이 아니라, AI 에이전트가 수행하는 다양하고 불규칙한 연산을 효율적으로 처리하는 기술이 필요하다”라고 설명했다.

김 교수의 Parallel System Architecture Lab(PSAL)에서는 △GPU △NPU(Neural Processing Unit, AI 가속기) △메모리 시스템을 연구하고 있다. 또한 데이터센터와 같은 대규모 시스템에서 AI 학습과 추론을 더욱 효율적으로 수행할 수 있도록 △시스템 소프트웨어 △프로그래밍 모델 △네트워킹도 함께 연구 중이다. 현재의 GPU는 딥러닝을 위한 시스템의 토대가 됐지만, AGI(Artificial General Intelligence)로 나아가기 위해서는 GPU에 기반한 시스템의 한계를 극복해야 한다. 따라서 연구실은 GPU 내부 자원의 낭비를 근본적으로 해결하는 GPU 구조를 설계하고, 이를 위한 프로그래밍 모델 및 컴파일러 개발을 목표로 하고 있다. 장기적으로는 △GPU △CPU △NPU 등 거대 시스템 내 다양한 연산기를 모두 호환되게 설계해 AI 에이전트가 요구하는 복잡한 연산을 효율적으로 처리하는 시스템 설계 기술을 개발할 계획이다. 이와 관련해 PSAL의 김 교수와 인터뷰를 진행했다.

현재 진행 중인 GPU 관련 연구에 대해 구체적으로 설명 부탁한다.

먼저 GPU 설계 자체를 향상하는 연구를 하고 있다. GPU가 스레드블록이라는 큰 연산 단위로 연산기 자원을 할당하는데, 이 과정에서 불규칙한 연산을 처리할 때 자원 낭비가 발생할 수 있다. 이를 개선하는 연구를 하고 있다.

또 GPU와 함께 시스템에 장착돼 GPU의 메모리 용량과 병목 문제를 해결하는 설계 연구를 진행하고 있다. 예를 들면 CXL(Compute Express Link)과 같은 인터페이스를 활용해 GPU에 가성비 좋은 추가 메모리와 연산기를 연결해 큰 데이터와 이에 대한 연산을 나눠서 처리하는 기술이 이에 해당한다. 이는 거대 언어 모델처럼 메모리가 많이 필요한 응용을 효율적으로 실행할 수 있도록 돕는다.

최근 GPU 기술의 주요 연구 동향과 앞으로의 발전 방향에 관해 설명 부탁한다.

GPU는 여러 측면에서 발전하고 있는데, 기본적으로 연산 성능을 높이기 위한 노력이 있다. 예를 들면 정밀도는 낮지만 빠르게 처리 가능한 4·6·8bit 부동소수점을 사용하는 텐서 코어(가속 유닛)를 탑재하도록 발전하고 있다. 또한 칩렛 구조를 활용해 여러 작은 칩을 하나의 패키지에 통합함으로써 생산 비용을 절감하는 방향으로 설계가 진화하고 있다. 전체 시스템의 비용 효율을 높이기 위해 고사양·저사양 GPU를 같이 사용해 데이터를 나눠서 처리하는 등의 대규모 시스템 구축에 대한 연구도 있다. 앞으로는 AI가 에이전트 형태로 발전하면서 GPU가 효율적으로 처리하기 어려운 연산의 비중이 커질 것으로 예상하는데, 이런 문제를 해결하기 위한 연구가 중요할 것 같다.